讲座主题:

主讲人姓名及介绍:

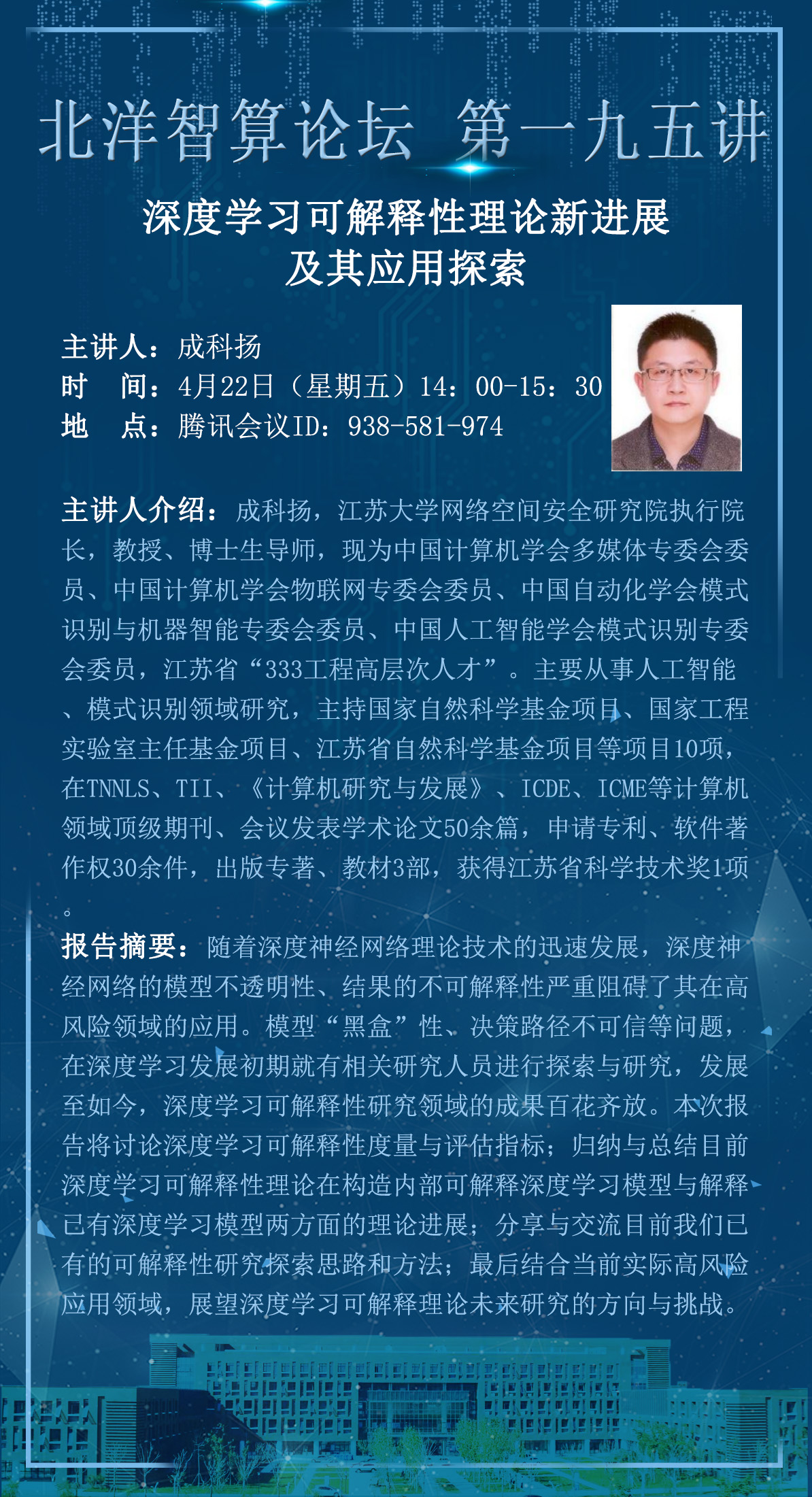

成科扬,江苏大学网络空间安全研究院执行院长,教授、博士生导师,现为中国计算机学会多媒体专委会委员、中国计算机学会物联网专委会委员、中国自动化学会模式识别与机器智能专委会委员、中国人工智能学会模式识别专委会委员,江苏省“333工程高层次人才”。主要从事人工智能、模式识别领域研究,主持国家自然科学基金项目、国家工程实验室主任基金项目、江苏省自然科学基金项目等项目10项,在TNNLS、TII、《计算机研究与发展》、ICDE、ICME等计算机领域顶级期刊、会议发表学术论文50余篇,申请专利、软件著作权30余件,出版专著、教材3部,获得江苏省科学技术奖1项。

报告摘要:

随着深度神经网络理论技术的迅速发展,深度神经网络的模型不透明性、结果的不可解释性严重阻碍了其在高风险领域的应用。模型“黑盒”性、决策路径不可信等问题,在深度学习发展初期就有相关研究人员进行探索与研究,发展至如今,深度学习可解释性研究领域的成果百花齐放。本次报告将讨论深度学习可解释性度量与评估指标;归纳与总结目前深度学习可解释性理论在构造内部可解释深度学习模型与解释已有深度学习模型两方面的理论进展;分享与交流目前我们已有的可解释性研究探索思路和方法;最后结合当前实际高风险应用领域,展望深度学习可解释理论未来研究的方向与挑战。