(通讯员 崔梦龙)计算语言学领域的两大国际组织——欧洲语言资源协会(ELRA)和国际计算语言学委员会(ICCL) ——联合组织了2024年计算语言学、语言资源和评估联合国际会议(LREC-COLING 2024),会议于5月20日至25日在意大利都灵举行。天津大学智能与计算学部自然语言处理团队论文《Towards Robust In-Context Learning for Machine Translation with Large Language Models》荣获LREC-COLING 2024杰出论文奖,其中学部朱少林和硕士生崔梦龙为共同第一作者,天津大学自然语言处理实验室负责人熊德意教授为通讯作者。

COLING是中国计算机学会推荐的B类会议。该会议最早可追溯至1965年,每两年举办一届,迄今已举办30届,是自然语言处理领域最具影响力的国际性会议之一。本届会议共收到投稿3470篇,最终接收1559篇,经过最佳论文评议委员会综合评判,最终8篇论文获得杰出论文,仅占会议录取论文的0.5%。

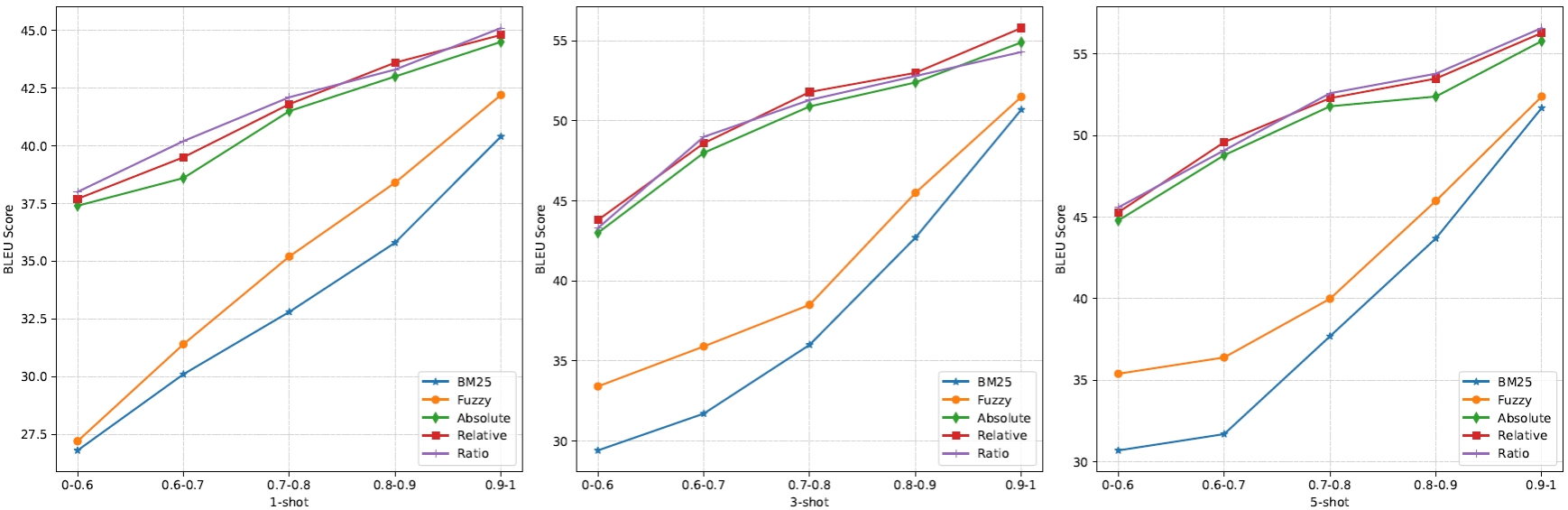

获奖论文简介:近年来,基于大语言模型上下文学习(ICL)进行自动翻译,已成为机器翻译领域中一个引人注目的研究方向。其主要思想是从额外的数据存储(平行语料库)中检索少量翻译样本,作为示例引导翻译,无需更新大语言模型参数。然而,检索到的示例通常存在潜在噪声,显著降低了大语言模型的翻译性能。在本文中,我们提出了一种创新方法,使大语言模型能够通过ICL实现鲁棒的翻译。该方法采用了多视角思想,同时考虑句子级和单词级信息,以选择出有效避免噪声的示例。在句子级别上,设计了基于margin的计分方法以避免语义噪声。在单词级别上,利用词嵌入评估相关单词,并改变示例中单词的权重。通过考虑句子和单词级别的相似性,所提出的方法提供了细粒度的示例,显著地提升了大语言模型的翻译性能。大量实验结果充分验证了该方法的有效性,尤其在领域适应方面。审稿人一致认为所提方法具有强创新性,效果显著,且易于复现,首次解决了大模型ICL机器翻译的鲁棒性问题。